En un mundo donde la inteligencia artificial (IA) se integra cada vez más en nuestra vida cotidiana, la cuestión de la seguridad de la IA se vuelve primordial y Google, uno de los pioneros en el campo de la IA, ha adoptado un enfoque proactivo para este problema con la creación de su Equipo Rojo de IA (AI Red Team).

Este equipo está dedicado a garantizar la seguridad de los sistemas de IA, simulando amenazas y ataques potenciales para identificar vulnerabilidades y fortalecer las defensas.

El Equipo Rojo de IA: Hackers Éticos para la Seguridad de la IA

El concepto de un Equipo Rojo proviene del ámbito militar, donde un equipo designado juega un papel adversario contra el «equipo local» para probar y mejorar sus defensas. El Equipo Rojo de IA de Google aplica este concepto a los sistemas de IA, simulando una variedad de adversarios que van desde estados nacionales y grupos de Amenazas Persistentes Avanzadas (APT) hasta hacktivistas, criminales individuales o incluso internos malintencionados.

El Equipo Rojo de IA no es solo un grupo de hackers tradicionales; también son expertos en IA, equipados con el conocimiento necesario para llevar a cabo ataques técnicos complejos en los sistemas de IA.

Aprovechan los conocimientos de los equipos de Inteligencia de Amenazas de Google de clase mundial como Mandiant y el Grupo de Análisis de Amenazas (TAG), así como la investigación sobre los últimos ataques de Google DeepMind.

Simulación de Ataques: Un Enfoque Proactivo para la Seguridad de la IA

Una de las responsabilidades clave del Equipo Rojo de IA de Google es adaptar la investigación relevante para trabajar contra productos y características reales que utilizan la IA. Simulan ataques para aprender sobre su impacto, generando hallazgos en las disciplinas de seguridad, privacidad y abuso.

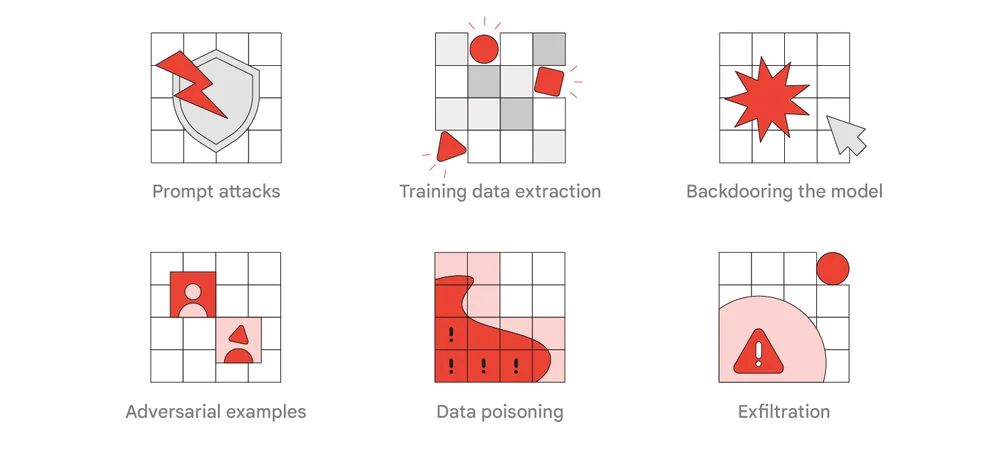

El equipo utiliza tácticas, técnicas y procedimientos (TTPs) de los atacantes para probar una gama de defensas del sistema. Estos TTPs incluyen ataques de solicitud, extracción de datos de entrenamiento, puertas traseras en el modelo, ejemplos adversarios, envenenamiento de datos y exfiltración.

Lecciones Aprendidas y Mirando al Futuro

Las simulaciones adversarias del Equipo Rojo de IA ya han demostrado ser exitosas, destacando posibles vulnerabilidades y debilidades en los sistemas de IA. Estos hallazgos han ayudado a anticipar algunos de los ataques que ahora se ven en los sistemas de IA.

El trabajo del equipo ha demostrado que los controles de seguridad tradicionales, como asegurar que los sistemas y modelos estén debidamente bloqueados, pueden mitigar significativamente el riesgo. Muchos ataques a los sistemas de IA pueden detectarse de la misma manera que los ataques tradicionales.

El Equipo Rojo de Google se ha adaptado a un panorama de amenazas en constante evolución desde su creación hace más de una década. El equipo ha sido un socio de entrenamiento confiable para los equipos de defensa en todo Google y su trabajo es un llamado a la acción para que otras organizaciones realicen ejercicios regulares de equipo rojo para ayudar a asegurar las implementaciones críticas de IA en sistemas públicos grandes.

Puntos Clave

- La Importancia del Equipo Rojo en la IA: El equipo rojo es una herramienta crucial para preparar a las organizaciones para posibles ataques a los sistemas de IA. Ayuda a identificar vulnerabilidades y fortalecer las defensas, garantizando el uso seguro y responsable de la tecnología de IA.

- La Complejidad de los Ataques de IA: Los ataques a los sistemas de IA pueden volverse rápidamente complejos y pueden no tener soluciones simples. Esto resalta la importancia de tener experiencia en la materia de IA dentro de los equipos rojos.

- La Necesidad de Ejercicios Regulares de Equipo Rojo: Google recomienda que cada organización realice ejercicios regulares de equipo rojo para ayudar a asegurar las implementaciones críticas de IA en sistemas públicos grandes. Este enfoque proactivo para la seguridad de la IA puede ayudar a anticipar y mitigar posibles amenazas.

El Equipo Rojo de IA de Google está liderando la carga en la seguridad de la IA, estableciendo un estándar para que otras organizaciones lo sigan. A medida que la IA continúa evolucionando y se integra más en nuestras vidas, el trabajo de estos hackers éticos se volverá cada vez más importante para garantizar la seguridad de los sistemas de IA.

por

por