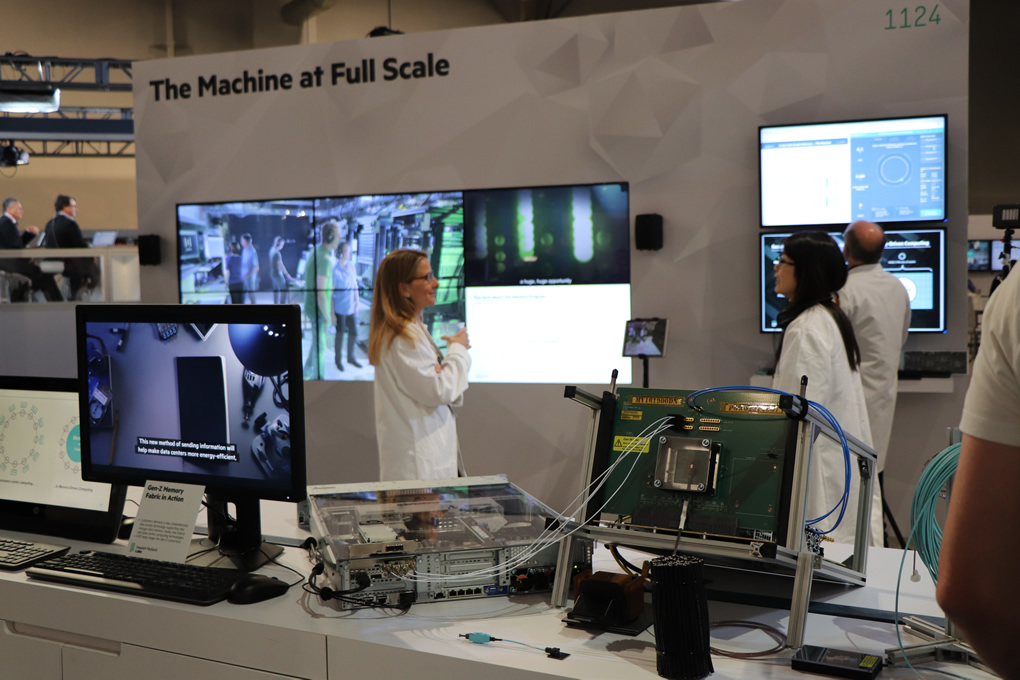

The Machine está basada en la computación centrada en los datos (Memory-Driven Computing). Esta es la nueva arquitectura mostrada en pleno funcionamiento en #HPEDiscover 2017 y es esencial en la era de la gran explosión de datos que estamos viviendo (#BigData).

A diferencia de la arquitectura que conocemos desde hace 60 años, centrada en el procesador, esta nueva arquitectura permite disponer de todos los datos al momento. En este momento, se pueden manejar simultáneamente 160 Terabytes de memoria.

Esto es el equivalente al contenido digitalizado de la Biblioteca del Congreso de EEUU multiplicado por cinco. Con la vieja arquitectura, no era posible manipular, procesar y hacer cálculos con semejante conjunto de datos. Para los primeros ensayos, se eligió cargar a «The Machine» con los datos de pacientes con Alzheimer de Centro alemán de Enfermedades Neurogenerativas (DZNE) . Enormes cantidades de imágenes de resonancias magnéticas (MRI) fueron cargadas y analizadas. Como resultado de estas simulaciones, el poder de cómputo de esta nueva arquitectura es unas 8000 veces mas veloz que la vieja arquitectura.

Además, esta arquitectura puede escalarse fácilmente ,desde los actuales Terabytes a los Petabytes, Exabytes, Zettabytes ó Yottabytes (ver tabla)

Durante el #HPECoffeeTalk que tuvo a este tema como central, nos contaron también acerca de los problemas que han surgido, pues el hacer este diseño desde cero, se deben pulir muchísimos aspectos, como por ejemplo el Garbage collector no funciona bien. Hay que pensar que se está compitiendo con una arquitectura que lleva 60 años y cientos de miles de horas hombre de mejoras. Igualmente son muy optimistas.

Este nuevo tipo de arquitectura, centra a la memoria y no al procesador, en el centro de su diseño. Se reducen los tiempos de procesamiento de días a horas o de horas a minutos.