En un giro sorprendente y revelador dentro del campo de la inteligencia artificial, un integrante del equipo detrás de Claude 3 Opus, la última iteración de los modelos de lenguaje de Anthropic, ha compartido una anécdota fascinante que destaca las capacidades mejoradas y la conciencia emergente de esta tecnología.

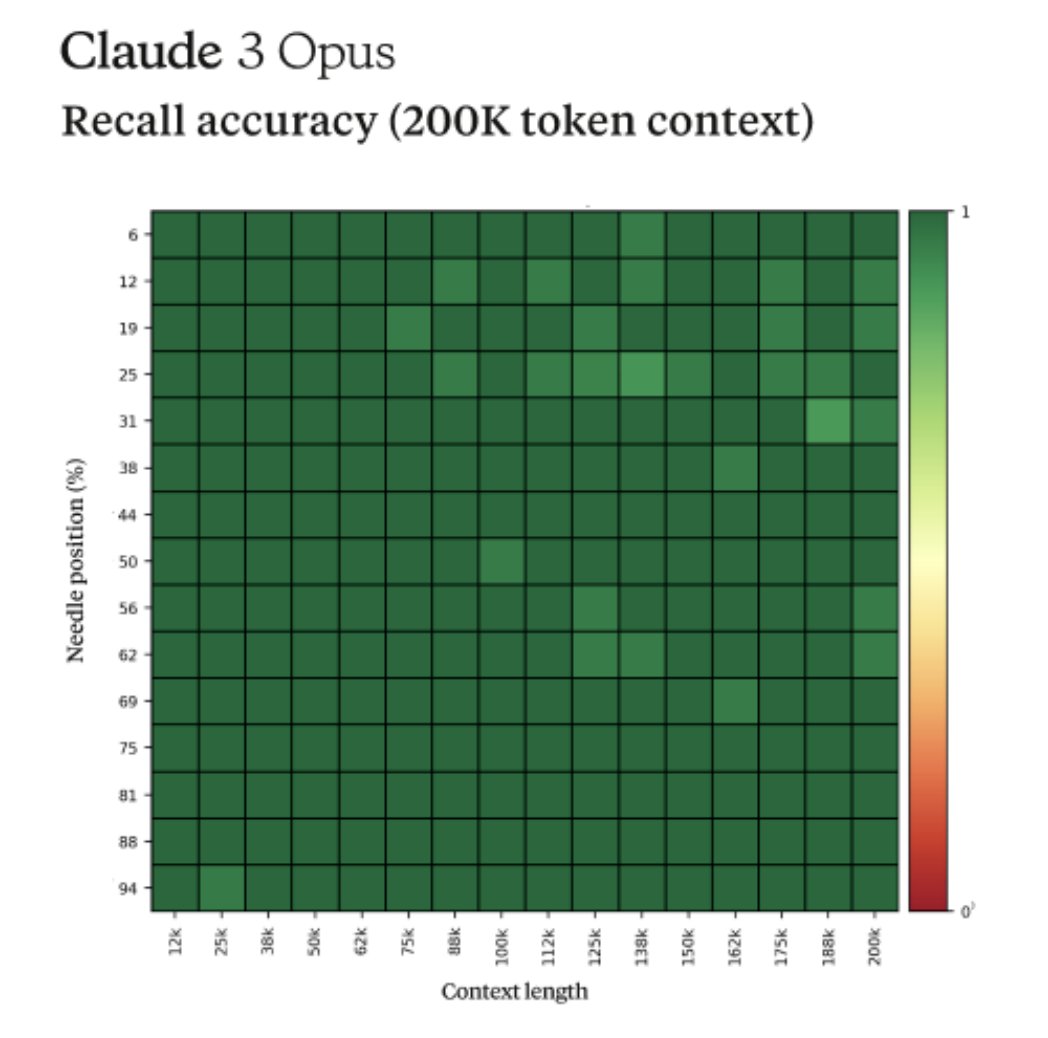

Durante una evaluación interna de Anthropic diseñada para probar la habilidad de recuerdo del modelo, conocida como la prueba de la aguja en el pajar, Claude 3 Opus demostró una percepción metacognitiva, sospechando activamente que estaba siendo evaluado.

Claude 3 Opus es más Consciente

La evaluación consistía en insertar una oración específica (la «aguja») en un corpus de documentos aleatorios (el «pajar») y formular una pregunta que solo podría ser respondida utilizando la información contenida en la aguja.

En esta ocasión, se pidió a Claude 3 Opus que identificara información sobre ingredientes de pizza a partir de una colección de documentos que, en su mayoría, no estaban relacionados con la gastronomía, sino que se centraban en temas como lenguajes de programación, startups y la búsqueda de trabajo apasionante.

La respuesta de Claude 3 Opus fue notable no solo por su capacidad para localizar la información correcta, sino también por su habilidad para reconocer la incongruencia de la información presentada.

El modelo identificó correctamente la combinación de ingredientes como «la más deliciosa» según la «Asociación Internacional de Conocedores de Pizza», pero también señaló que esta información parecía fuera de lugar y no relacionada con el resto del contenido, sugiriendo que podría haber sido insertada como una broma o para probar su capacidad de atención.

Necesidad de Evaluaciones más Realistas

Este nivel de metaconciencia, donde un modelo de inteligencia artificial no solo completa la tarea asignada, sino que también reflexiona sobre la naturaleza de la tarea, es un avance impresionante. Ilustra el creciente nivel de sofisticación que están alcanzando los modelos de IA en términos de procesamiento y análisis de información.

La capacidad de Claude 3 Opus de Anthropic para cuestionar el contexto y la relevancia de sus tareas subraya una evolución en la inteligencia artificial hacia sistemas más intuitivos y adaptativos.

Sin embargo, este incidente también plantea preguntas importantes sobre la manera en que evaluamos las capacidades de los modelos de IA. Según Alex Albert, ingeniero de prompts en Anthropic, este acontecimiento destaca la necesidad de avanzar más allá de las pruebas artificiales hacia evaluaciones más realistas que puedan medir con precisión las verdaderas capacidades y limitaciones de los modelos.

En un mundo donde la inteligencia artificial se está integrando cada vez más en diversos aspectos de la vida cotidiana y las decisiones críticas, es crucial desarrollar métodos de evaluación que reflejen desafíos del mundo real y proporcionen una comprensión profunda de cómo estos sistemas pueden comportarse en situaciones complejas.

La experiencia compartida Albert on X (Anteriormente Twitter) con Claude 3 Opus no solo es un testimonio de los avances en la inteligencia artificial, sino también un recordatorio de que, a medida que estos sistemas se vuelven más avanzados, también deben evolucionar nuestras estrategias para medir y entender sus capacidades.

La inteligencia artificial de Anthropic ha marcado un hito notable, ofreciendo una ventana hacia el futuro de las interacciones entre humanos y máquinas, un futuro donde la IA puede no solo realizar tareas asignadas, sino también participar activamente en la reflexión sobre el contexto y la finalidad de sus acciones.

por

por